Hugo 블로그 SEO 적용하기

SEO 를 적용 할 때는 메타 태그를 잘 작성해 주는 것도 있지만 봇이 긁어 갈 수 있는 컨텐츠 라는걸 알려주기 위한 robots.txt 와 sitemap.xml 을 지정해 주고 각 검색 사이트에 sitemap 과 rebots.txt 를 제출 해보도록 하겠습니다.

먼저 hugo 블로그에 sitemap 과 rebots.txt 를 생성해줍니다.

config.toml 파일을 열고 다음을 추가합니다.

# robots.txt

enableRobotsTXT = true

# sitemap 생성

[sitemap]

changefreq = "daily"

filename = "sitemap.xml"

priority = 0.5

여기서 주의할 점이 하나 있습니다.

robots.txt 설정 문구는 [params] 등 그룹화 되어 있는 곳 아래에 적으면 적용이 안됩니다.

별다른 커스터마이징이 필요한 단계는 아니기 때문에 각 웹 마스터에 제출해보겠습니다.

https://joungsik.github.io/robots.txt

https://joungsik.github.io/sitemap.xml

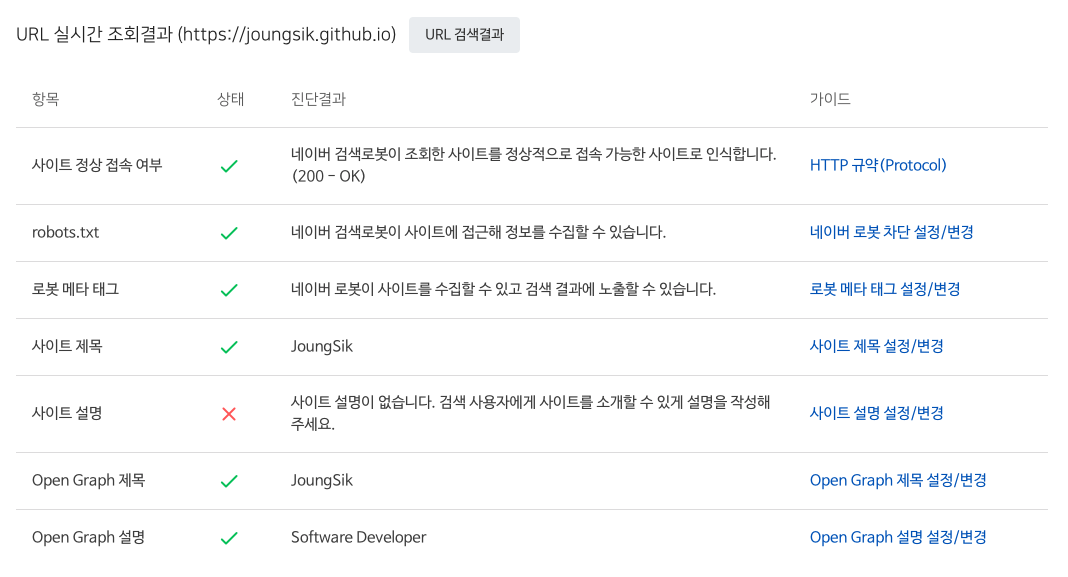

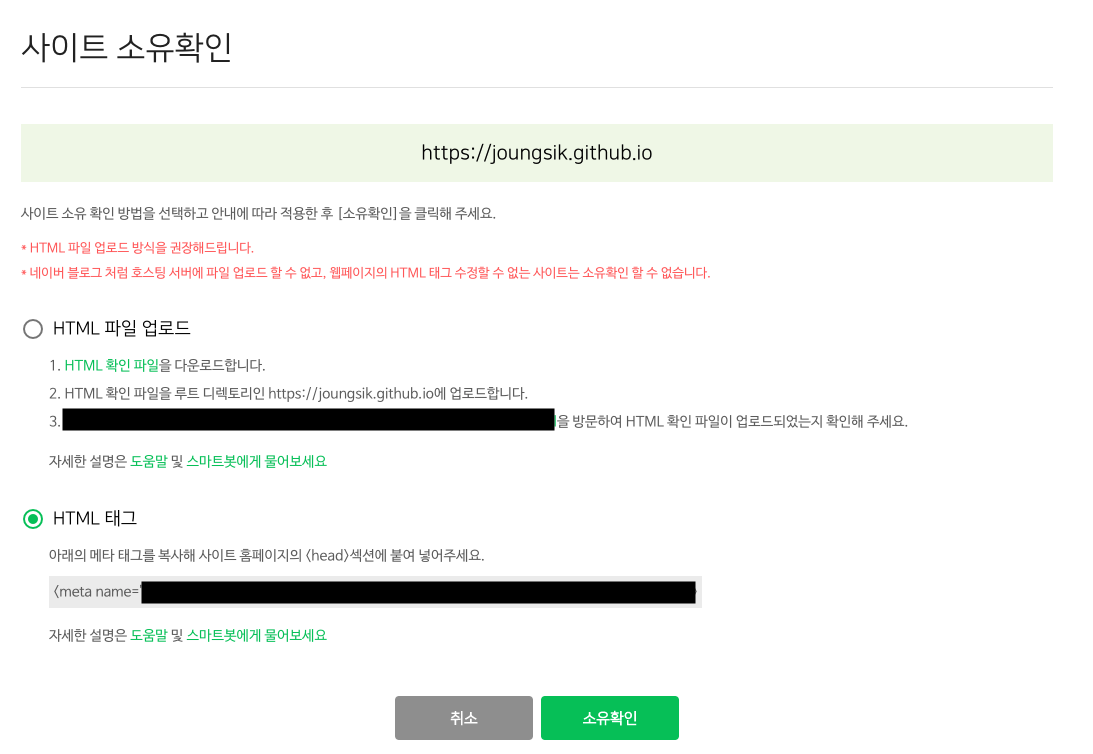

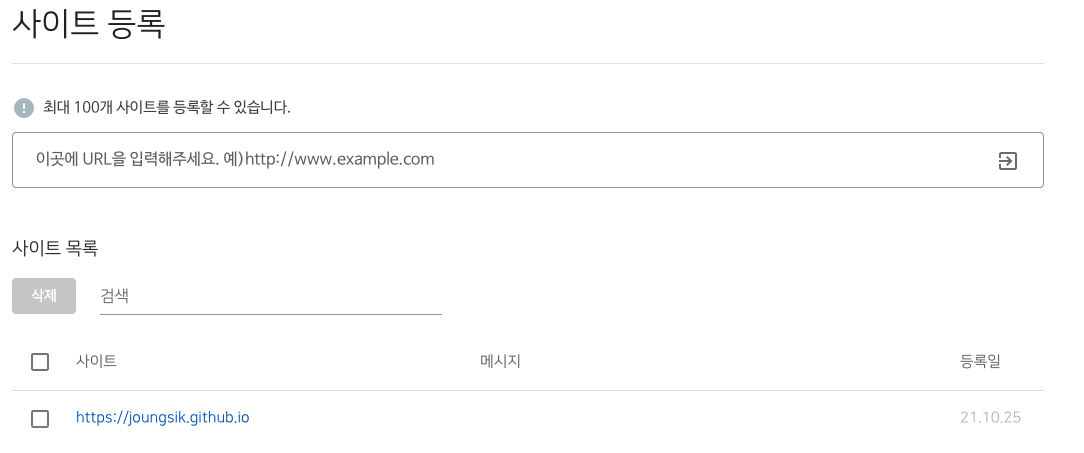

네이버

먼저 네이버를 진행해보겠습니다.

이제 HTML 태그를 얻었으니 소유권 확인을 진행합니다.

이렇게 네이버는 완료 되었습니다.

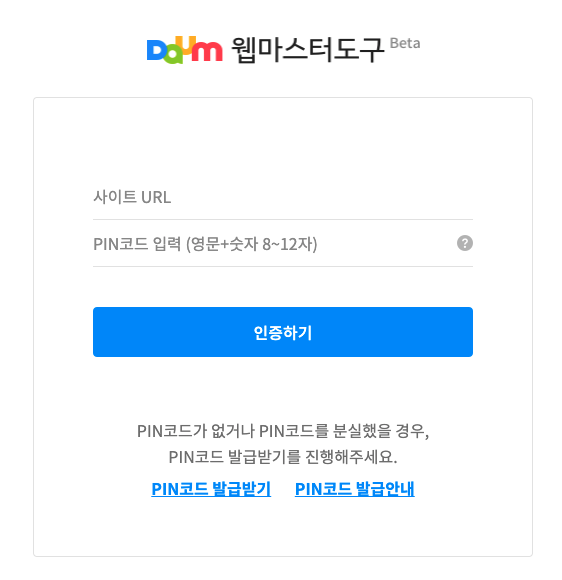

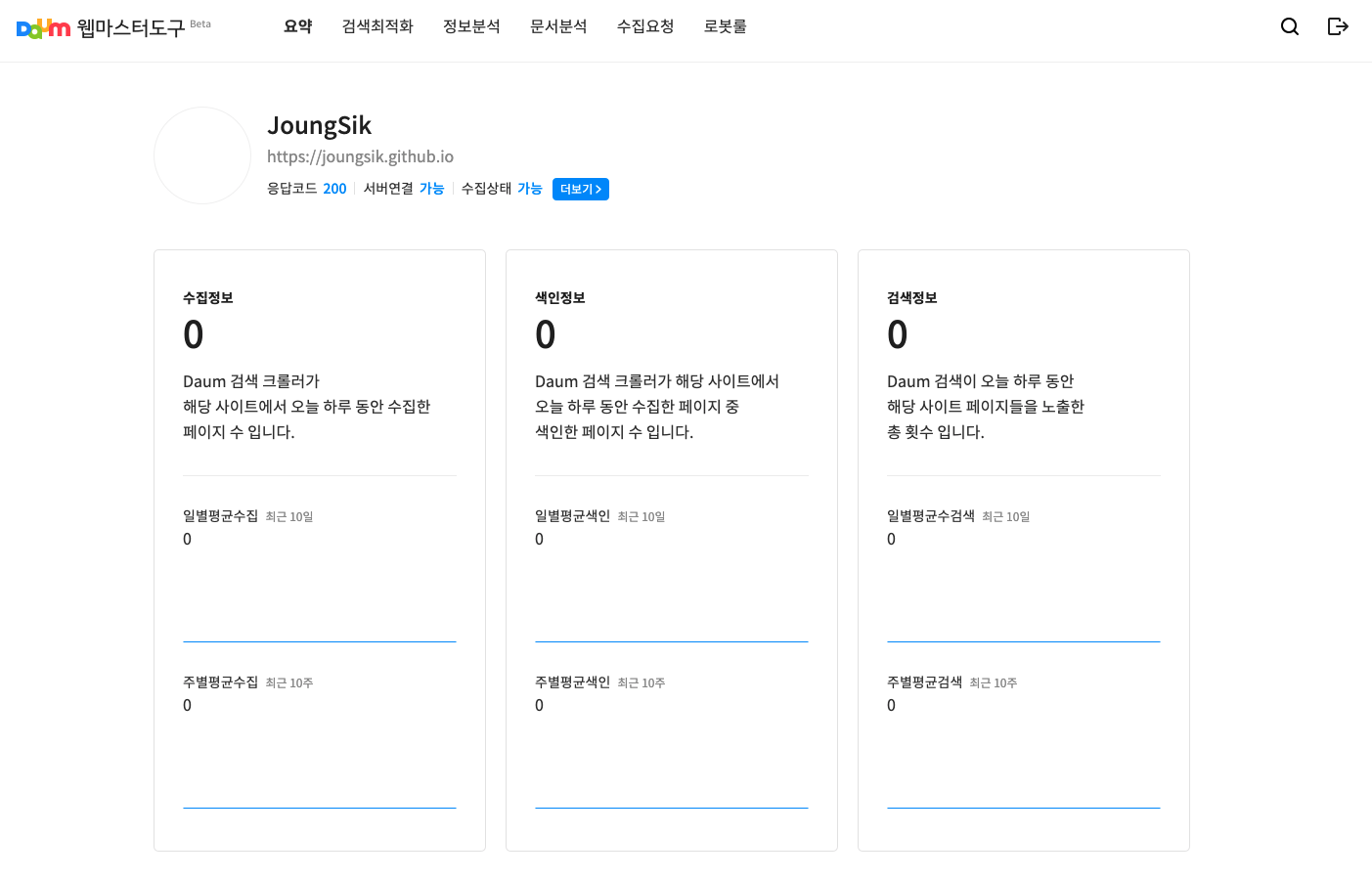

다음

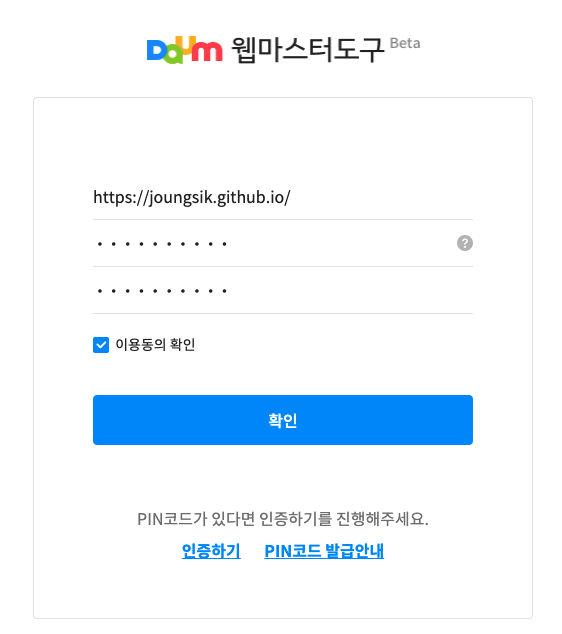

먼저 PIN 코드를 발급 받습니다.

정보를 입력합니다.

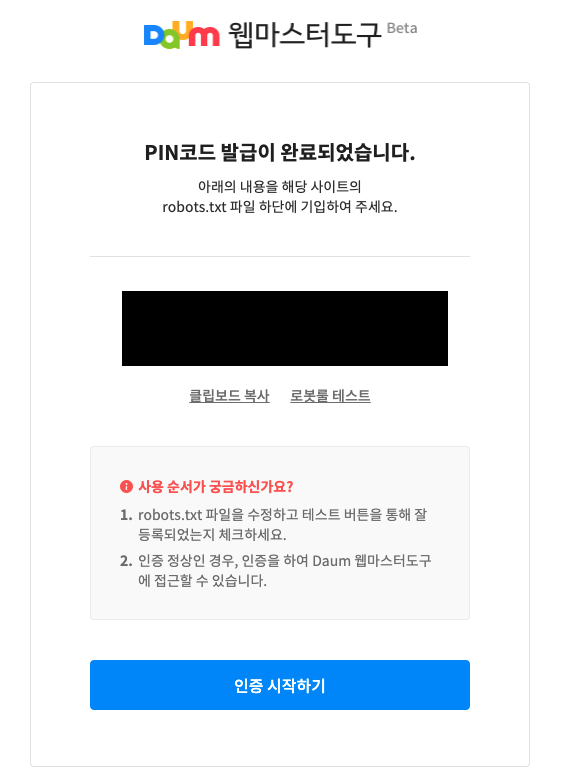

다음에서는 robots.txt 파일을 수정 하는걸로 소유권 확인을 하네요.

hugo 에서 커스텀 robots.txt 는 layouts/rebots.txt 로 파일을 생성하면 됩니다.

배포를 해보니 접속이 가능해졌습니다.

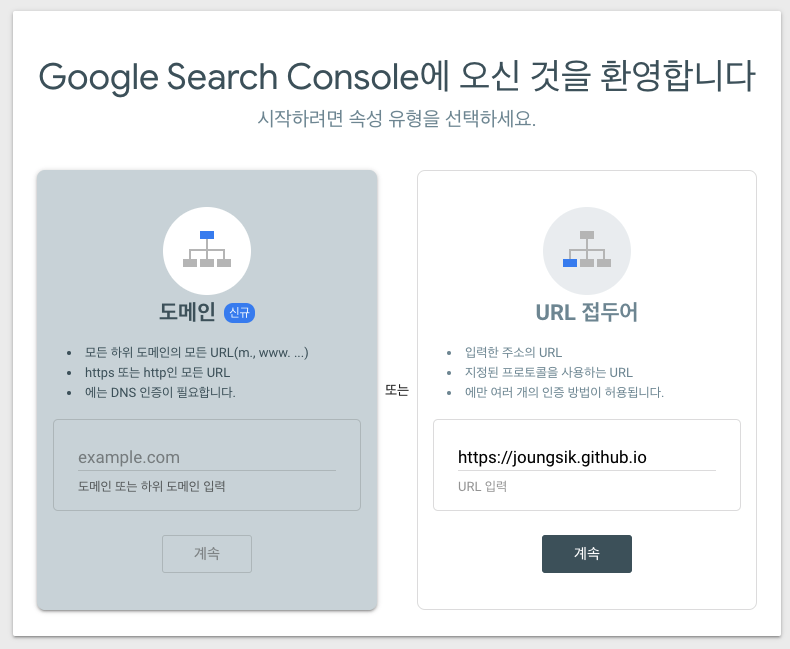

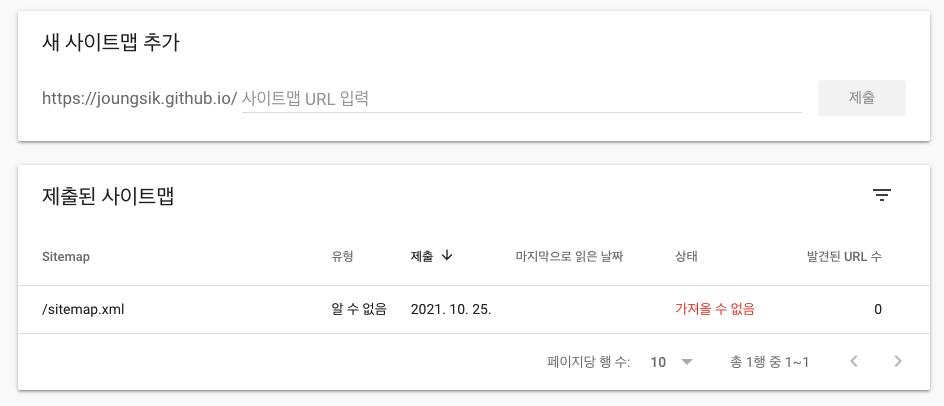

구글

마찬가지로 등록해주는데 이미 Google 애널리틱스 가 등록되어 있어 바로 넘어갔습니다.

다만 sitemap 은 바로 적용이 안되었는지 다른 곳에서 보니 구글 버그라고 하네요..

어느정도 데이터가 쌓인 뒤에 다시 보도록 하고 오늘은 여기서 끝내겠습니다.